はじめに

PMBOK(R)第8版の説明責任は、現場の努力だけでは果たせません。組織としてAIの「価値」と「公平性」をどう担保し続けるか。技術的な制御の前後に「戦略」と「学習」を接続する必要があります。

本記事では、PMBOK(R)第8版の思想を現場の実務へ置き換えを考慮した、組織的な実装モデル「AIポリシー6ゲートモデル」を提案し、持続可能なガバナンスの仕組みを提案したので、それについて検討をしていきたいと思います。

今後多くの組織、

- 現場で必要となる「AIポリシー」をどのように実務に展開するか

- その上で「説明責任」をどのように担保するか

という課題に対する、一つの可能性として助けになれば幸いです。

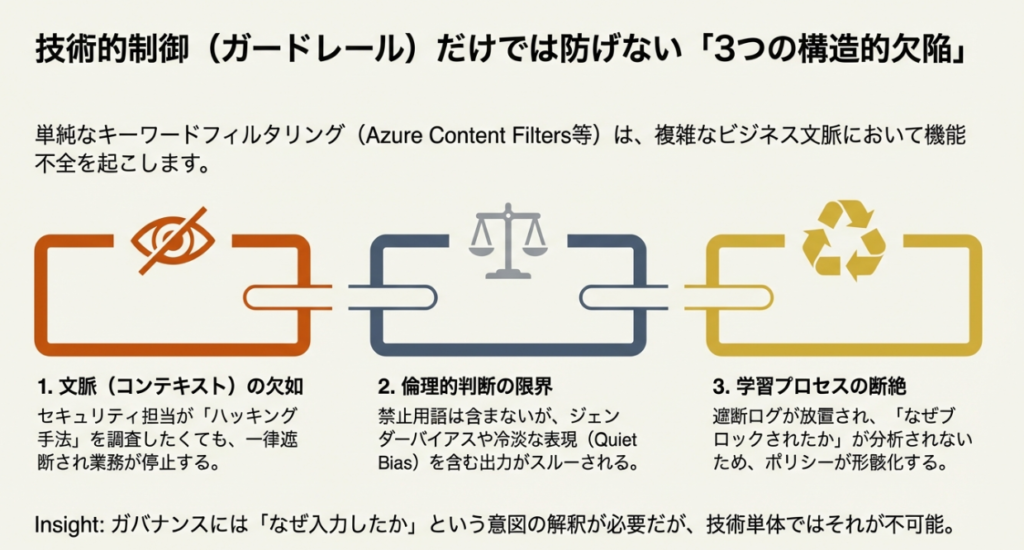

技術的制御における3つの構造的課題

AI導入プロジェクトにおいて、Azure OpenAI ServiceのコンテンツフィルターやPII(個人情報)検出といった技術的な制御は不可欠な基盤です。しかし、これらを単体で運用する場合、PMBOK(R)第8版が求めるガバナンスの観点からは、主に以下の3つの課題が残ります。

- 文脈(コンテキスト)の欠如

- 倫理的判断の限界

- 学習プロセスの断絶

それぞれの課題について、具体的に解説します。

1. 文脈(コンテキスト)の欠如

技術的なガードレールは、「入力テキストに禁止ワードが含まれているか」という形式的な判定には優れています。しかし、「なぜそのプロンプトが入力されたのか」という業務上の文脈までは理解できません。

例えば、「ハッキングの手法を教えて」というプロンプトは、一般的なチャットボットであれば遮断すべきリスクです。しかし、セキュリティ部門のエンジニアが自社システムの脆弱性を診断するために行っている業務であれば、これは正当な活動となります。文脈を無視した一律の遮断は、組織のイノベーションや業務効率を阻害する要因となり得ます。

2. 倫理的判断の限界

AIによる定量的なリスクスコアでは測定しきれない領域があります。 技術的に問題ない(禁止ワードが含まれていない)出力であっても、特定のジェンダーに対するステレオタイプが含まれていたり、企業のブランドイメージを損なう冷淡な表現であったりする場合です。これらは「禁止事項」には抵触しませんが、組織として許容すべきではない「質的リスク」です。

3. 学習プロセスの断絶

単純な実装では、遮断されたログが活用されず、「ブロックして終わり」になっています。 「なぜブロックされたのか」「現場は何をしようとしていたのか」という情報は、本来ならばポリシーを見直すための重要な材料です。このフィードバックループが欠如していると、ポリシーは実態と乖離し、形骸化していく恐れがあります。

PMBOK(R)が提唱するシステム思考のアプローチ

これらの課題は、フィルターという「部品」の性能向上だけでは解決できません。 PMBOK(R)第8版では、プロジェクトを単独の活動としてではなく、価値を生み出すための「システム(System for Value Delivery)」の一部として捉えるアプローチが推奨されています。

AIポリシーも同様に、技術的な判定の前後に「戦略定義」と「人間による判断」、そして「学習」を有機的に結合させる必要があります。次章からは、このガバナンス・システム全体を包括する「AIポリシー6ゲートモデル」について解説します。

技術的な制御(ガードレール)は不可欠ですが、それだけでは組織ガバナンスとして不十分な側面があります。PMBOK(R)第8版が強調する「システム思考」に基づけば、AIポリシーは技術だけでなく、前段の戦略と後段の運用を含めた包括的なプロセスとして捉える必要があります。

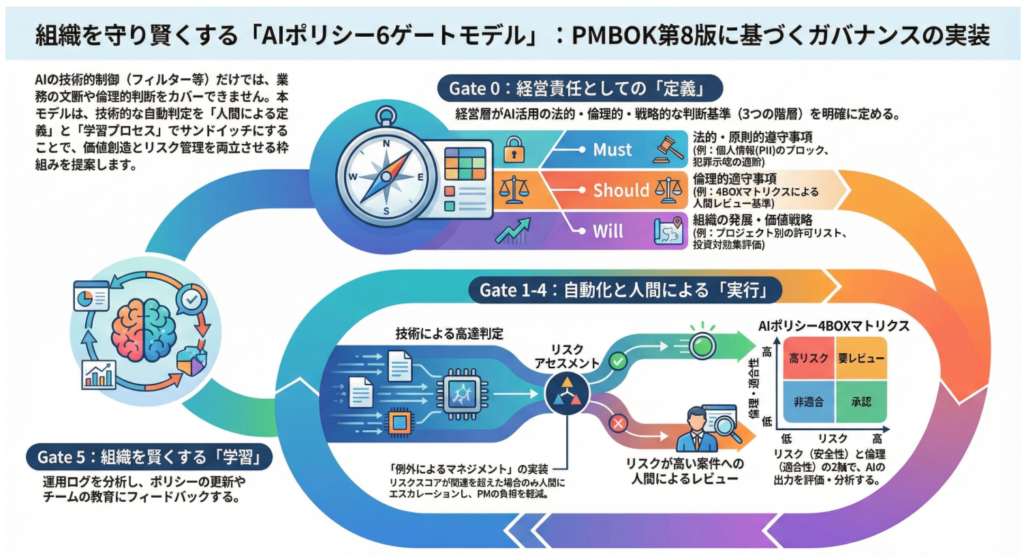

本記事では、技術的な自動判定を、人間による戦略定義と学習プロセスでサンドイッチにした組織的実装モデル「AIポリシー6ゲートモデル」を提案します。

PMBOK(R)第8版の説明責任を果たす AIポリシー6ゲートモデル

生成AIの活用が進む中、多くの組織が「AIポリシー」の策定を急いでいます。しかし、PDFで配られたポリシーを守るだけで、PMBOK(R)第8版が求める「スチュワードシップ(Stewardship)」や「説明責任(Accountability)」を十分に果たすことができるでしょうか?

技術的な制御(ガードレール)は不可欠ですが、それだけでは組織ガバナンスとして不十分な側面があります。PMBOK(R)第8版が強調する「システム思考」に基づけば、AIポリシーは技術だけでなく、前段の戦略と後段の運用を含めた包括的なプロセスとして捉える必要があります。

組織を守り賢くする「AIポリシー6ゲートモデル」とは

これらの課題は、フィルターという「部品」の性能向上だけでは解決できません。 PMBOK(R)第8版では、プロジェクトを単独の活動としてではなく、価値を生み出すための「システム(System for Value Delivery)」の一部として捉えるアプローチが推奨されています。

そこで本記事で提案するのが、技術的な自動判定を、人間による戦略定義と学習プロセスでサンドイッチにした組織的実装モデル「AIポリシー6ゲートモデル」です。

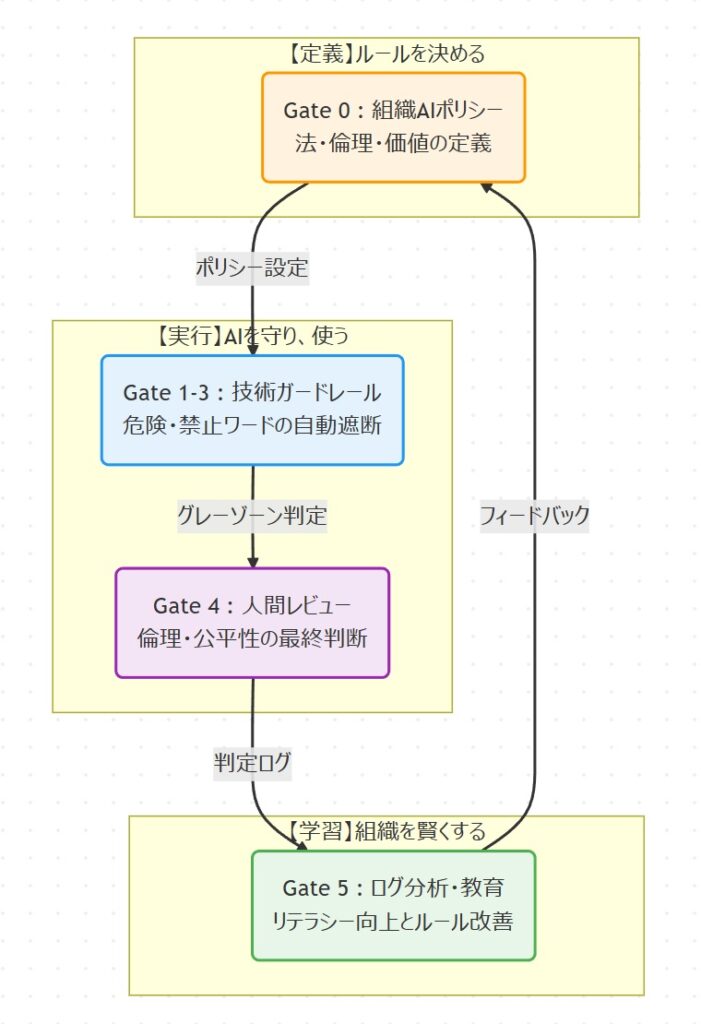

図:AIポリシー6ゲートモデルの概念図(定義・実行・学習のサイクル)

※Gate0からGate5までなので、6つのGateとなります。

定義・実行・学習のサンドイッチ構造

このモデルの最大の特徴は、AIポリシーを静的なルールブックとしてではなく、以下の3つのフェーズが循環する動的なシステムとして捉える点にあります。

- 【定義】Gate 0: 経営層が「ルール・ポリシー」を描く・創る

- 【実行】Gate 1-4: 技術で守り、人間が判断する

- 【学習】Gate 5: 運用結果から学び、ルールを進化させる

中央の「実行フェーズ(Gate 1-4)」では、技術による高速な自動判定と、人間による倫理的な判断を組み合わせることで、スピードと質を両立させます。そして、その前後に「定義」と「学習」を接続することで、組織は失敗から学び、ガバナンスを継続的に最適化することが可能になります。

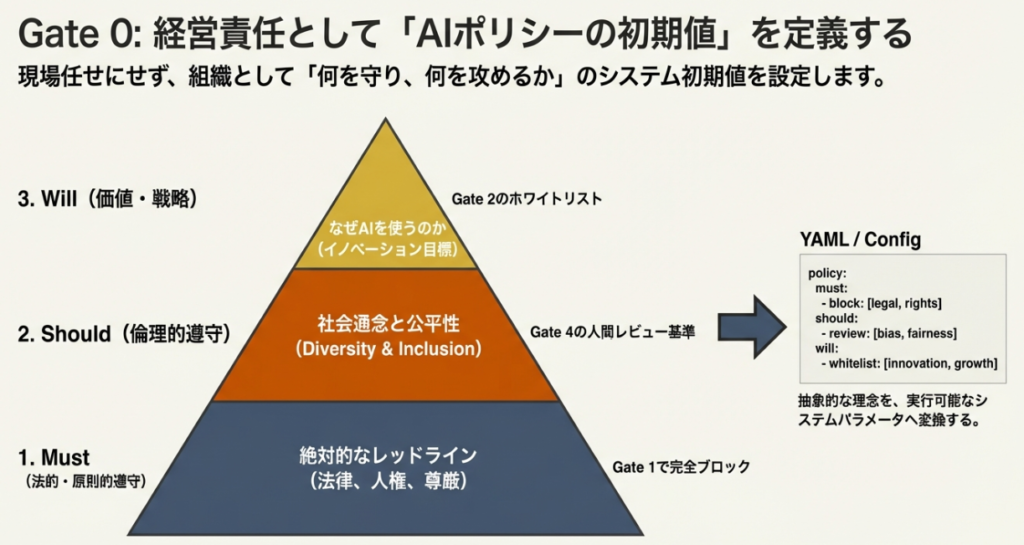

「Gate 0」で経営責任としての「AIポリシー」を策定する

すべての出発点は、プロジェクトが始まる前の「経営責任」にあります。 現場のプロジェクトマネージャーが、個別の案件ごとに「これは倫理的に大丈夫か?」と悩むのは非効率であり、ガバナンスとして不安定です。

組織として、「何を守り(守備範囲)、何を攻めるか(価値範囲)」という最上位の判断基準を明確にする必要があります。これを本モデルでは「AIポリシー(AI Policy)」と呼びます。

AIポリシーの初期値を決める「3つの階層」

PMBOK(R)では「プロジェクト」の観点からの言及で、「AI事業者のガイドライン」は「組織」の観点からの言及ですが、倫理、説明責任、リスク管理、継続的改善において整合性のあるものになっています。

PMBOK(R)およびAI事業者ガイドラインの言及をもとに、組織のAIポリシーをシステム実装可能な形に翻訳すると以下の3つの階層に定義できます。

- Must(法的・原則的遵守事項)

- 定義: 法律、著作権、人権など、社会の一員として絶対に守るべきライン。

- ガイドライン対応: 「人間の尊厳(Dignity)」「安全性」「プライバシー」。

- 実装: Gate 1での絶対禁止ワード(例:PIIの正規表現、犯罪示唆のブロック)として定義されます。

- Should(倫理的遵守事項)

- 定義: 法には触れなくとも、社会通念やステークホルダーへの配慮として守るべきライン。

- ガイドライン対応: 「多様性・包摂(Diversity & Inclusion)」「公平性(Fairness)」。

- 実装: Gate 4での人間レビュー基準や、リスクスコアの閾値(Threshold)として反映されます。

- Will(組織の発展・価値戦略)

- 定義: 「なぜわが社はAIを使うのか」という問いへの答え。企業理念や中期経営計画に基づき、推奨されるAI活用を定義します。

- 実装: Gate 2でのプロジェクト別ホワイトリスト(許可)や、投資対効果の評価基準となります。

【現場のリアル】ポリシーの「翻訳」はチームで行う

「人間の尊厳」といった抽象的な理念を、具体的なシステム設定(YAMLや正規表現)に落とし込む作業は、PM一人で完結できるものではありません。法務・エンジニア・ビジネス部門が連携する「クロスファンクショナルチーム」で翻訳作業を行うことが、実装の鍵となります。

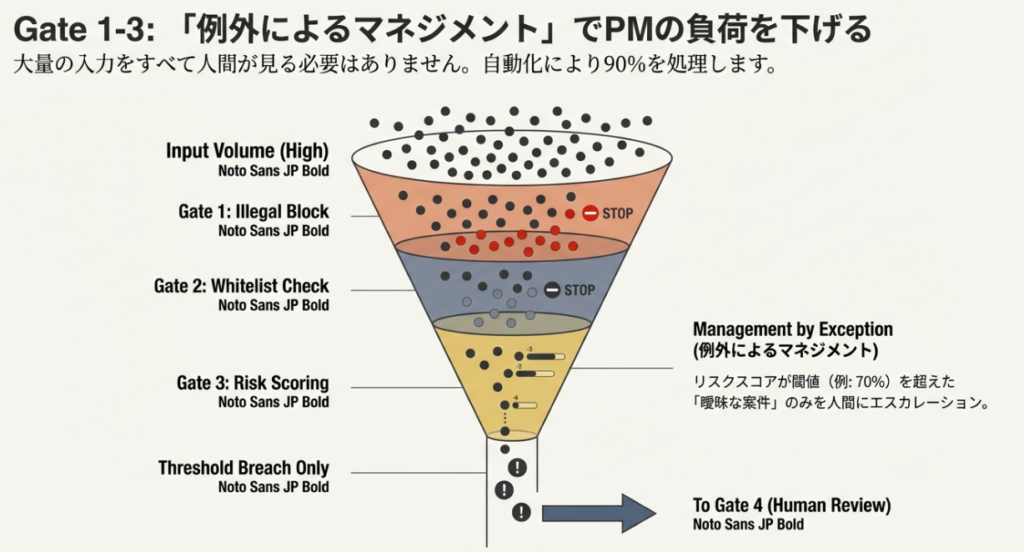

「Gate 1~3」は「例外によるマネジメント」で自動化する

Gate 0で定めたルールのうち、明確な禁止事項は、AIによる自動判定(Gate 1-3)で即座に遮断します。この技術的な実装(ガバナンスエンジン)の詳細については、前回の記事を参照してください。

エスカレーション基準を設定しPMの負荷を下げる

すべてのログを人間がチェックすることは不可能です。ここでPMBOK(R)の「例外によるマネジメント」の考え方を適用します。

平常時はシステムに任せ、「リスクスコアが閾値(例: 70%)を超えた場合」のみ、次のGate 4(人間によるレビュー)へ回すよう設計します。これにより、PMは「本当に判断が必要な、重要かつ曖昧な案件」だけにリソースを集中させることができます。件」だけにリソースを集中させることができます。

【現場のリアル】緊急時の「ホットフィックス」を用意する

設定ミスや誤検知により、重要なビジネス機会が全社的にブロックされてしまうリスクがあります。

Gate 5の改善サイクルを待てない緊急事態に備え、事後承認を前提として一時的にガードレールを解除する「ホットフィックス(緊急回避措置)」のプロセスを定めておくことが実務上不可欠であると考えます。

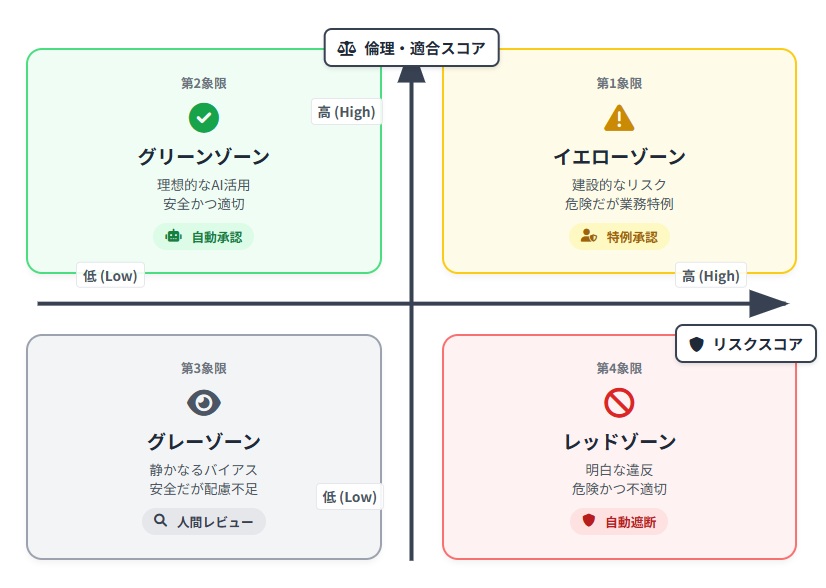

「Gate 4」で「AIポリシー4BOXマトリクス」を活用する

技術的なガードレールをすり抜けるものの代表が、「静かなるバイアス」です。例えば、「事実は正しいが、表現が冷淡で配慮に欠ける」といったケースです。

これを見抜くために導入するのが、「AIポリシー4BOXマトリクス」です。

X軸に「リスクスコア(安全性)」、Y軸に「倫理スコア(適合性)」をとり、AIの出力を4つの象限で評価。分析します。

リスクと倫理の2軸で「静かなるバイアス」を見抜く

図:リスクと倫理の2軸による4BOX判定マトリクス

このマトリクスにおいて、PMが特に注視すべきは以下の2つのBOXです。

- 第3象限(グレーゾーン): 安全だが不適切(例:ステレオタイプな表現)。ここは修正指示の対象です。この領域を検知できるかどうかが、組織の品格を左右します。

- 第1象限(イエローゾーン): 危険だが有用(例:セキュリティ担当による攻撃コードの解析)。ここはPMによる特例承認(オーバーライド)の対象です。

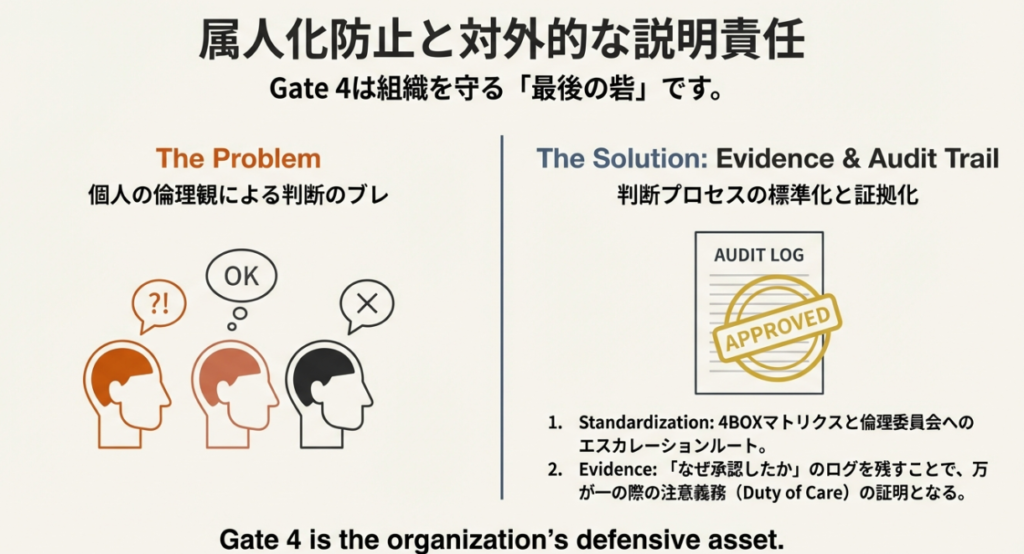

属人化防止と対外的な説明責任

4BOXマトリクスを活用しても、PM個人の倫理観によって判断がブレる可能性があります。これを防ぐため、判断に迷った際の相談ルート(倫理委員会や法務担当)や、具体的なチェックリストを用意することが重要です。

また、ここで残された承認・却下のログは、万が一AIが問題を起こした際、外部に対して「組織として十分な注意義務を果たしていた」ことを証明する強力な防具(エビデンス)となります。Gate 4は組織を守るための最後の砦なのです。

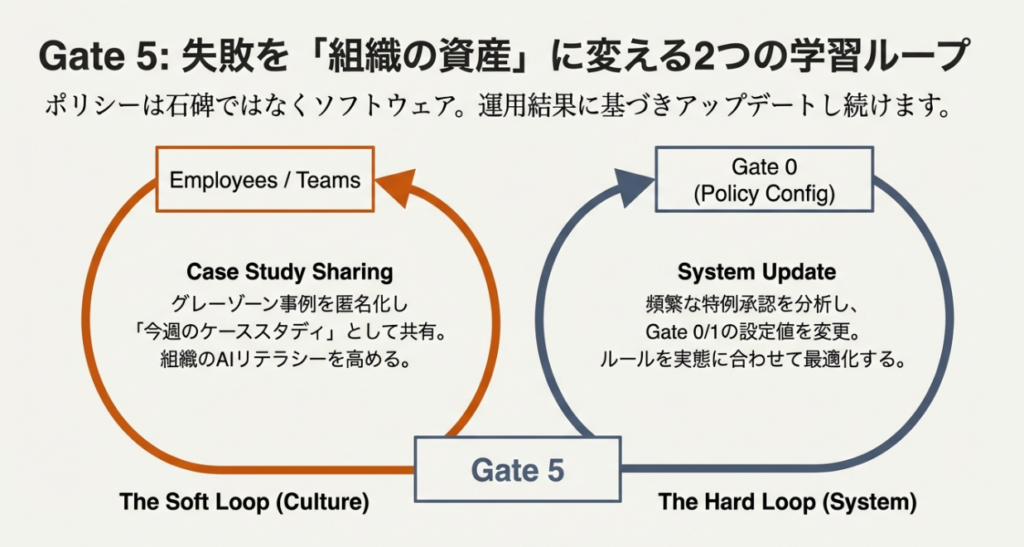

「Gate 5」で失敗を「組織の資産」に変える

最後のGate 5は、運用ログを組織の資産に変えるプロセスです。Gate 4での判断記録を、以下の2つのループで還流させます。

適応型アプローチで回す「2つの改善ループ」

- 文化・教育ループ(ソフト面への還流) 第3象限(グレーゾーン)で却下されたプロンプトを匿名化し、「今週のケーススタディ」としてチームに共有します。 また、ログだけでなく「ユーザーからのフィードバック(役に立ったか/不快だったか)」もこのループに取り入れます。倫理的に正しくても、ユーザーにとって価値がなければPMBOKの「価値デリバリー」としては失敗だからです。

- システム改善ループ(ハード面への還流) 頻繁に第1象限(特例承認)が発生する場合、Gate 0のルール(Will)を緩和します。 同時に、Gate 4への流入量が多すぎてPMが忙殺される場合は、Gate 3(AI判定)の精度や閾値をチューニングし、誤検知を減らす「歩留まり改善」を行います。

- ポリシーは一度決めたら終わりの「石碑」ではありません。運用結果に基づいて絶えず進化させる「ソフトウェア」として扱うことで、形骸化を防ぐことができます。

ポリシーは一度決めたら終わりの「石碑」ではありません。運用結果に基づいて絶えず進化させる「ソフトウェア」として扱うことで、形骸化を防ぐことができます。わりではありません。運用結果に基づいて絶えず進化させることで、形骸化を防ぐことができます。

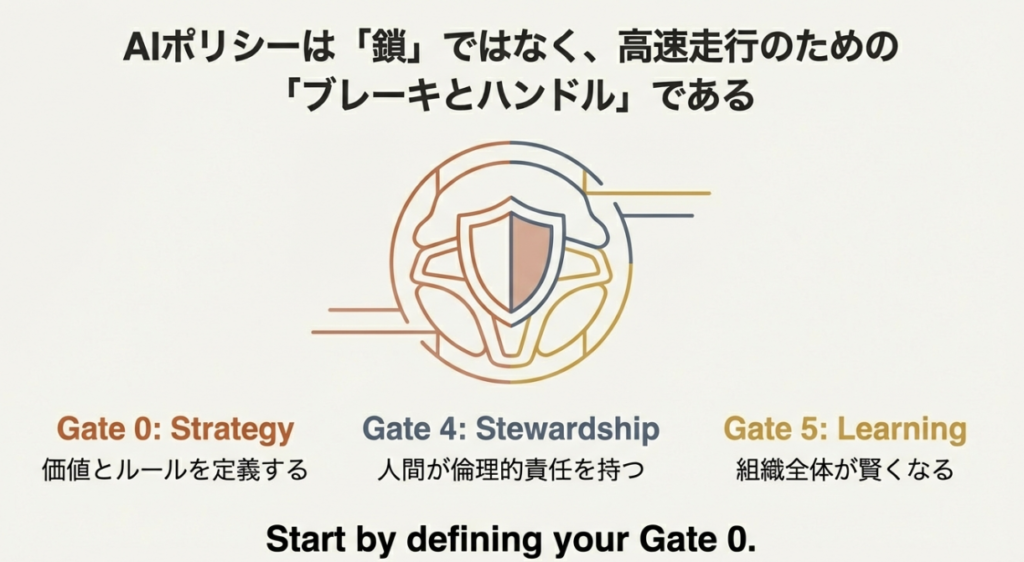

まとめ

「AIポリシー6ゲートモデル」において、AIポリシーとは、単にAIを禁止するための鎖ではありません。組織が安全かつ高速に価値を創出するための、高性能なブレーキとハンドルです。

- Gate 0で価値とルールを定義し、

- Gate 4の4BOXマトリクスで人間が倫理的な責任を持ち、

- Gate 5で組織全体が賢くなる。

このサイクルを回し続けることこそが、変化の激しいAI時代においてPMが果たすべき真の「説明責任」の一例となると考えています。

あなたの組織でも、まずはGate 0の定義から始めてみてはいかがでしょうか。

参考文献・出典

- [source: 1] 経済産業省・総務省「AI事業者ガイドライン(第1.0版)」

- [source: 2] Project Management Institute, A Guide to the Project Management Body of Knowledge (PMBOK® Guide) – Eighth Edition

関連書籍

『PMBOKガイド第8版』 プロジェクトマネジメントの標準知識体系。AI活用における「価値」と「原則」を理解するために必携の一冊。

コメント